A szegedi bölcsészkaron a plágiumszabályzatba már bekerültek a mesterséges intelligenciával íratott beadandók, a Műegyetem pedig részt is vesz az MI-szűrés fejlesztésében. Közben bár van olyan felismerőprogram, amely magyarul is érzékelni tudja, ha egy szöveget a ChatGPT készített, a szakmában már elkezdtek azon is gondolkodni, a technológiai versenybe lépéshátránnyal való beszállás helyett hogyan lehetne újragondolni a módszereket.

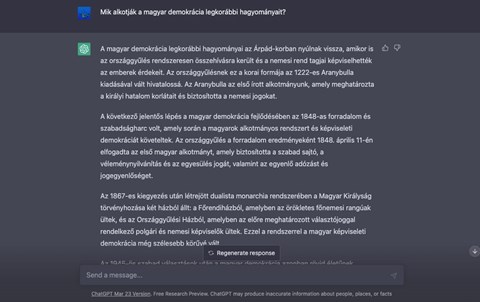

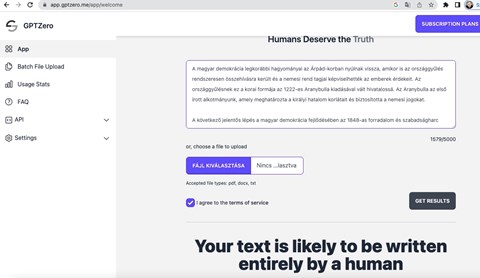

A ChatGPT mesterséges intelligenciát (MI) használó nyelvi modell, bár olykor létrehoz magyartalan szóalakokat és sosemvolt eseményekre is emlékszik, egész jó minőségben képes sok forrást felhasználva esszét, akár beadandót is írni, ezzel jelentős kihívás elé állítva egyetemeket már idehaza is. Több hazai intézményt is megkerestünk ezzel kapcsolatban, a Szegedi Tudományegyetem (SZTE) például azt közölte: a ChatGPT használatában leginkább érintett területeken – mivel egyes karokon nem érzik, hogy az MI már veszélyt jelentene, máshol viszont már most kihívás a hagyományos számonkérési módszerekkel kapcsolatban – már most is használnak olyan detektáló alkalmazásokat, mint például a GPTZero.

„Megvannak azok a módszerek, amikkel látható, hogy nem önálló munkáról van szó, bár a magyar nyelvvel, egyediségéből adódóan, a jelenlegi detektálórendszerek még nem birkóznak meg”

– mondta Bányász Péter kiberbiztonsági szakértő, a Nemzeti Közszolgálati Egyetem Közszervezési és Infotechnológiai Tanszékének oktatója idén februárban a HVG-nek adott interjújában. És valóban, az SZTE által említett GPTZeróba próbaképpen bemásoltunk egy, a ChatGPT-vel frissen generáltatott magyar szöveget, amit viszont teljesen ember által írottnak vélt, vagyis nem ismerte fel a csalást. Két másik utasításra generált magyar szöveggel ugyanígy jártunk. (A hasonló nevű, de teljesen külön ZeroGPT rendszerrel szintén, igaz, az az egyik alkalommal a túl rövid szövegre panaszkodott.) Amikor egy hasonló szöveget angolul írattunk, azt már felismerte.

|

Hogy működik az MI-felismerés? |

|

Az említett GPTZerót januárban a Princeton Egyetem 22 éves számítástechnika-szakos – egyébként újságíró minoros – hallgatója, Edward Tian indította el. A rendszere leginkább azon alapszik, hogy az MI sokkal kiszámíthatóbban ír, mint egy ember. Két tulajdonságát vizsgálja a beletáplált szövegeknek. A fejlesztő elmondása szerint az egyik a „zavarodottságuk”, a másik pedig a „kiugrásaik”. Az első gyakorlatilag a véletlenszerűséget méri, hogy egy nyelvi modell számára mennyire ismerős egy-egy szöveg. Ha nem az, akkor valószínűbb, hogy ember alkotta. (Ezek alapján a magyar szövegek fel nem ismerésében vélhetően szerepet játszhat az, hogy keveset használhatták még magyarul, azaz a gépi öntanulás még nem juthatott messzire a mi nyelvünkön. A rendszert azonban folyamatosan fejleszti a készítője.) A második tényező pedig a szövegen belül a mondatok összetettségére utal. Tian magyarázata szerint ugyanis az emberek gyakran váltogatják, mennyire hosszú és bonyolult mondatokban fogalmaznak, az MI-re ez viszont kevésbé jellemző. Így, ha egy diagramon felrajzolja a szöveg mondatainak változékonyságát, az emberi szövegekben lesznek kiugrások, míg a gépi szövegek mondatai elég hasonlóak lesznek. Ez a két tényező az, amely alapján a program megpróbálja beazonosítani, hogy ember írt-e egy szöveget vagy sem. Fejlesztője szerint azért nem lesz gond azzal, hogy lépést tartson a folyamatosan fejlődő MI-rendszerekkel, mert szerinte egy ilyen, érzékelő modellt jóval könnyebb betanítani, mint egy források millióival dolgozó nyelvi modellt. „Úgy is mondhatnám, a ChatGPT-t nem lehet létrehozni a téli szünetben egy kávézó ingyenes wi-fijéről, ahogyan a GPTZerót” – fogalmazott Edward Tian, aki szerint az íráskészség ezután is fontos lesz. |

MI kontra MI

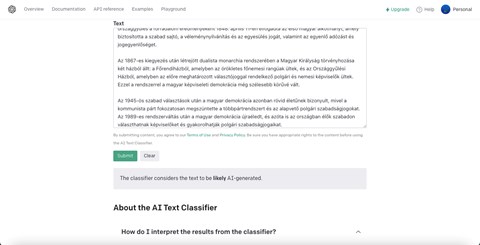

Ha a helyzet nem lenne még eléggé olyan, mint egy valóra vált Black Mirror-rész, akkor tegyük hozzá: a ChatGPT-t működtető Open AI maga is kifejlesztett egy február óta elérhető, szintén MI-alapú detektort az általa generált szövegek felismerésére, kifejezetten az egyetemi csalások kérdése miatt is. Amit pedig a ChatGPT friss tapasztalatok szerint segíthet kijátszani. De ne szaladjunk ennyire előre: ugyanis a cikk írásának ezen a pontján elért a hűha-élmény. Az Open AI saját rendszere ugyanis harmadjára felismerte saját gyermekét és a fenti, a korai magyar demokráciáról szóló szöveget valószínűleg MI-készítette alkotásnak titulálta.

A heuréka-érzést azonban gyorsan beárnyékolta, hogy ezután próbából bemásoltam ennek a készülő cikknek pár részletét is, amiről viszont már nem tudta eldönteni, hogy én írtam-e vagy nem. Az Open AI a detektor mellett készített egy információs oldalt is, ahol igyekeznek picit árnyalni a ChatGPT-ről kialakult képet. Szerintük ugyanis a rendszerük sok területen hasznos lehet az oktatásban, lehet vele például óraterveket vagy kvízkérdéseket gyártatni. Azt azonban elismerik, sok intézmény nem készült még fel az MI-generálta szövegek okozta dilemmákra, de azt írják, azt nem javasolják, hogy megbüntessék a használatáért a diákokat, hacsak nem kötötték ki előre világosan, hogy mik az ezzel kapcsolatos szabályok.

Ahogyan az általuk is kínált felismerő programokról is hangsúlyozzák, azok még távolról sem tökéletesek és üzembiztosak, valamint könnyen tévedhetnek. Ráadásul – teszik hozzá – a diákok könnyen megtanulhatják, hogyan módosítsanak pár szót a generált szövegekben úgy, hogy azt már ne azonosítsa MI-termékként a rendszer. Egyszóval óva intenek attól, hogy kizárólag erre támaszkodjanak az egyetemeken.

Már csak azért is, mert a detektort maga a ChatGPT is meg tudja vezetni, ha kifejezetten arra kap utasítást, hogy írjon úgy, hogy az ne legyen felismerhető egy MI-detektorral. Erre az NBC News hírportálja hívta fel a figyelmet, ugyanis rengeteg témában kipróbálták, hogy ha arra kérik a rendszert, úgy írjon, hogy azt ne jelölje meg MI-generált szövegként egy felismerő program, akkor ezt sikerrel megteszi és az Open AI saját rendszere sem ismeri fel a szövegek eredetét. Amikor például a főleg az Y- és Z-generáció által használt Discordról kérdezték ilyen módon, a rendszer elkezdett a hétköznapi angolban használt rövidítéseket (pl. chattin’) használni, hogy így „vágja át” fejlesztő cége detektorát. Mi is kipróbáltuk, nekünk is sikerült olyan szöveget kérnünk ilyen instrukciókkal, amit nem szúrt ki a detektor.

A plágiummal egy kategóriában?

Az SZTE-n ChatGPT-s vagy más MI-csalás miatt még nem indult fegyelmi ügy az egyetem lapunknak küldött válasza alapján, de azt is hozzáteszik: ennek elsősorban az az oka, hogy az ilyen eseteknek az objektív bizonyíthatósága még nincs kidolgozva. Fenyvesi Anna, aki az intézmény bölcsészkarán lévő Angol-Amerikai Intézet vezetője egy márciusi, alapvetően zártkörű szakmai műhelybeszélgetésen – a Szeged.hu beszámolója szerint – azt mondta, karukon több hallgató írásaival kapcsolatban is felmerült már annak gyanúja, hogy azok a ChatGPT-vel készültek.

Ezért – ahogyan már több nyugat-európai egyetemen is büntetik az azzal való visszaélést – az SZTE bölcsészkarán is februárban módosították a plágiumszabályzatot, melyben már az is szerepel, hogy „a plágiummal azonos elbírálás alá esik a mesterséges intelligencia bármely formájával – részben vagy egészben – készült munka” is. Fenyvesi egy márciusi konferencián azt mondta, egy januári online vizsgán vette észre, hogy egy hallgatójától ChatGPT által generált válaszokat kapott. Az Eötvös Loránd Tudományegyetem (ELTE) szakmai rendezvényén egyébként – az Index beszámolója alapján – ki is alakult egy vita arról, hogy érdemes-e a plágiummal egy kategóriába tenni az MI-szövegeket. Darázs Lénárd, az ELTE jogász tanára szerint nem, mert az ilyen szövegekben nincs olyan, ami szerzői jogot sérthetne.

Kérdés, hogy mennyire tudják ellenőrizni mindezt. Lévén, még a plágiumkereső szoftverek sem épp tökéletesek. (Egyébként az egyik legismertebb ilyen alkalmazás, a Turnitin készítői is nemrég előálltak a maguk MI-keresőjével.) Jogi karokon például előfordul az a probléma, hogy egy-egy beadandót plágiumként jelölnek meg, holott csupán annyi történt, hogy a jogi szakkifejezéseket muszáj egy az egyben úgy megjelölni, ahogyan az a jogszabályokban szerepel. Ezek pedig néha olyan hosszúak, hogy egy-egy bekezdés nagy részét is kiteszik, ezek után pedig már könnyen plágiumot jelezhet a rendszer ott is, ahol csupán egy jogászhallgató tartotta a formai kereteket.

Persze ez a kisebbik baj, hiszen itt egy oktató rá tud nézni és meg tudja állapítani, hogy nincs itt semmi látnivaló. Azonban, ahogyan a fenti példa mutatja, magyarul a detektáló rendszerek még elég kezdetlegesek. Ugyanakkor az SZTE-nél Péter Róbert, a BTK Angol Tanszékének oktatója például optimista, a már említett beszélgetésen ugyanis azt mondta: a szövegek szerzőazonosításának módszere, ahol azt kell eldönteni, a hallgató saját szövegét tartjuk-e a kezünkben, vagy abban az MI „keze” is benne van, meggyőzően eredményesnek látszik.

Ezt erősítheti a nemzetközi tapasztalatok egy része is, Darren Hicks, a dél-karolinai Furman Egyetem filozófiaprofesszora például egy Facebook-posztban számolt be arról, hogy amikor először találkozott egy ChatGPT-esszével, abban a mondatok helyesen voltak megírva, de az egésznek egyszerűen nem volt értelme. Egy másik, a Vice-nek nyilatkozó professzor arról számolt be, egy szövegnél azért kezdett gyanakodni, mert az elképesztően fals dolgokat tartalmazott.

„A mondatok külön-külön értelmesek voltak, de együtt nem igazán”.

– fogalmazott. Az amerikai lap cikke szerint a professzorok már kezdik felismerni – és megosztani egymás közt – azokat a módokat, ahogyan a rendszer hibázik. Egy oktató a lapnak azt mondta, hogy a rendszer hajlamos általános, bájos közhelyekkel teletűzdelt szövegeket generálni (ezt mi is tapasztaltuk, amikor érettségi esszéket írattunk vele), melyek egy kollégája szerint csak addig tűnnek jónak, amíg valaki nincs benne egy kicsit mélyebben a témában.

A szegedi műhelybeszélgetésen egyébként az is elhangzott: a ChatGPT és más MI-szolgáltatások használata jogilag még nem igazán tisztázott. Bár Tribl Norbert, a jogi kar adjunktusa szerint minősülhet csalásnak, bitorlásnak és a szerzői jogok megsértésének is, ha a diák MI-generálta szöveget ad be, számos kérdés még nyitott. Például az MI-generálta tartalmak szerzői joga egyelőre senkit sem illet meg, mert a szerzővé váláshoz egy ember alkotására lenne szükség. (Erről egy korábbi HVG-cikkben olvashatsz bővebben.) Ezeket vélhetően néhány éven belül vélhetően tudni fogja kezelni a jog és a társadalom, ugyanakkor az ilyen jellegű kérdések már napirenden vannak, ez látható abból is, hogy például a szegedi egyetem – legalábbis bizonyos karai – mennyire komolyan veszi a kérdést.

De más intézmények is mozgolódnak az ügyben. A Budapesti Műszaki és Gazdaságtudományi Egyetem (BME) azt írta kérdésünkre: MI-csalással még nem szembesültek, de aktívan részt vesznek olyan szoftverfejlesztésében, amely a mesterségesen és emberi módon generált szövegek szétválasztását célozza. Úgy látják ugyanis, az MI-generálta szövegek szűrésére a meglévő eszközöknek még szükséges a további fejlesztése.

A Budapesti Corvinus Egyetemtől azt a választ kaptuk, hogy közvetlen tapasztalataik és technikai megoldásaik még nincsenek az MI témájában, inkább beszélgetés indult el a témáról, több szakmai eseményt szerveztek már az egyetemen a témáról oktatóiknak és hallgatóiknak. Reakciójuk szerint még náluk sem derült ki olyan eset, amikor egy hallgató a ChatGPT-vel készített volna beadandót. A Budapesti Gazdasági Egyetemnél (BGE) sem tudnak még ilyenről, válaszuk alapján még nincs is megoldásuk a szűrésre, de keresik rá a módszereket.

Szélmalomharc helyett

„A végső megoldás vélhetően azonban nem itt keresendő, mivel ezzel csak egy fokozódó technológiai verseny indulna be, amelynek során a csalások kiszűrése folytonos lépéshátrányban lenne”

– ismeri el az SZTE lapunknak küldött válaszában. Hozzáteszik: „fontos ezen eszközök használata mellett a számonkérés módjainak áttekintése, hogy az egyrészt a mesterséges intelligencia-alkalmazásoknak kevésbé kitett elemeket is tartalmazzon, másrészt több lépcsőben, több megközelítésből keresztlogikával ellenőrizze, hogy a számon kért tudástartalomnak a hallgató az egyszerű tudásreprodukción túlmenően birtokában van-e.”

Radó Péter oktatáskutató szerint is csak ez a megoldás. „Előre kell menekülni, nem lehet szembe menni az új technológiákkal, amik megjelennek” – fogalmazott kérdésünkre. Mint mondta, egyetemi oktatóként ő is sokat gondolkodott róla, hogy az értékelést hogyan lehet újragondolni, de még csak „barátkozik a gondolattal”. Hozzáteszi: egyelőre visszatért a szóbeli vizsgákhoz, nem irat esszéket, de nem csak emiatt.

A Műegyetem pedig lapunknak küldött válaszában kiemelte: a műszaki-mérnöki területen a „beadandók” jórészt valamilyen alkotás, rendszer, folyamat, illetve berendezés tervezését jelentik. „Ezek hangsúlyos eleme az egyéni kreativitás, ahol a mesterséges intelligencia még nem rúg labdába” – fogalmaztak.

„A felsőoktatás évszázadok óta arra épül, hogy a hallgató olvas, tanul, elsajátítja az ismereteket, és azokról a számonkérések alkalmával írásban beszámol, majd végül önálló írott munkát, például szakdolgozatot, disszertációt ad be. Ennek vethet véget a ChatGPT”

Radó szerint ez a helyzetértékelés helyes, de a ChatGPT önmagában nem fogja kizökkenteni azokat a pedagógusokat, oktatókat, akik a hagyományos ismeretátadó órakra alapoznak. Úgy látja, a hagyományos lexikális tudáson alapuló oktatást már egyébként is sok tényező kikezdte, de ezt önmagában egy ilyen nyelvi modell nem fogja felgyorsítani. „Aki átállt egy másfajta oktatói módszertanra, az ettől függetlenül már megtette, vagy meg fogja tenni” – fejtette ki lapunknak. Mint mondja, ő nem dimenzionálná túl az ilyen rendszerek szerepét és szerinte a középiskolában sokkal nagyobb problémákat okozhat, mert ott pedagógusok előszeretettel iratnak például otthoni esszéket.

Mezei Péter, az SZTE Egyetemi Doktori Intézet vezetője pedig az MI etikus használatát sürgette a felsőoktatásban, ahogyan lapunknak küldött válaszában a Corvinus Egyetem is. Hiszen az MI-vel nem csak csalni lehet, hanem nyíltan és átláthatóan is bele lehet építeni például egy szakdolgozatba. Az International Baccalaureate nemzetközi érettségi programot működtető szervezet például nemrég arról nyilatkozott: náluk forrásként az esszékben fel lehet használni a ChatGPT válaszait, melyet úgy kezelnek, mint bármely más forrást, úgy is kell azokat hivatkozni. Az Open AI is írja az oktatóknak szánt információs oldalán, hogy a hallgatók Bibtex-formátumban fel tudják tüntetni a rendszert forrásanyagként, ahol kiadóként a céget kell megjelölni.

Ugyanakkor – természetesen más forrásokhoz hasonlóan – a ChatGPT olykor fals válaszokat is generál, néha nemlétező szerzők soha meg nem írt műveit is ismerni véli. Az MI „black box” problémája miatt pedig még a legújabb, fizetős verzióban is csak részben lehet visszakövetni, egy-egy válaszhoz milyen forrásokat használt fel. A korábbi változat pedig kifejezetten rossz volt még e tekintetben. Az ELTE konferenciáján Aczél-Partos Adrienn, a Pázmány Péter Katolikus Egyetem Jog-és Államtudományi Karának munkatársa ki is emelte, hogy egyelőre a ChatGPT nem használható tudományos munkákhoz, ugyanis nem tudja kijelentéseit alátámasztani, és hivatkozásokat sem tud mondani. Szerinte a hipotézis és az absztrakt megalkotásában ugyanakkor segíthet.

|

Áldás is, nem csak átok |

|

Természetesen nem csak kihívás, de lehetőség is a mesterséges intelligencia rengetegféle felhasználása az egyetemek számára. A BGE-nél például azt írták, az azóta távozott Palkovics László egykori technológiai és ipari miniszter által kezdeményezett és 2018-ban megalakult Mesterséges Intelligencia Koalíció tagjaként elkötelezettek az MI tanításában és gyakorlati alkalmazásában is. Az intézmény több karán, például a Pénzügyi és Számviteli Kar gazdaságinformatikus alapképzésén oktatják is a mesterséges intelligenciát és sok olyan digitális rendszerük van, ahol a folyamatok adatelemzésekkel gyorsíthatók, vagy kiterjeszthetők. Példaként említik az új típusú e-learningeket, a hallgatói életút segítését vagy a lemorzsolódás csökkentését. Négy éve a Microsoft Magyarországgal közösen hoztak létre az egyetemen MI tudásközpontot, a hallgatói ügyintézés javítására pedig például egy chatbot bevezetését is tervezik – közölték kérdésünkre. A BME-től azt írták: az MI-ről egyelőre csak pozitív tapasztalatuk van. A kutatásával több szinten is foglalkoznak és kutatói-fejlesztői tapasztalatuk azt igazolja: „sok probléma megoldására nyújt gazdag tárházat” a MI és a rendszerek teljesítőképességét is jelentősen növeli. Az SZTE kutatócentrumai is régóta foglalkoznak az MI elméleti, jogi kérdéseivel és gyakorlati alkalmazásaival is, az egyetem kutatói ki is fejlesztettek egy szövegbányászati alkalmazást. Mint kérdésünkre közölték, a kutatások eredményeit eddig is beépítették az egyetemi oktatásba. Válaszuk szerint a ChatGPT-nél is vizsgálják az oktatásban felhasználható előnyeit is a visszaélések kiszűrése mellett. |

(Kiemelt kép: Matheus Bertelli, Pexels)